Definición

Se denomina variable aleatoria discreta aquella que sólo puede tomar un número finito de valores dentro de un intervalo. Por ejemplo, el número de componentes de una manada de lobos, pude ser 4 ó 5 ó 6 individuos pero nunca 5,75 ó 5,87. Otros ejemplos de variable discreta serían el número de pollos de gorrión que llegan a volar del nido o el sexo de los componentes de un grupo familiar de babuinos.

Densidad

Se denomina densidad discreta a la probabilidad de que una variable aleatoria discreta X tome un valor numérico determinado (x). Se representa:

-

-

-

-

-

- f(x) = P[X=x]

-

-

-

-

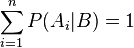

La suma de todas las densidades será igual a 1

-

-

-

-

-

- DISTRIBUCIÓN DE PROBABILIDAD DE VARIABLES

- ALEATORIAS DISCRETAS

- ESPACIO MUESTRAL. El conjunto de todos los resultados posibles de un experimento estadístico

- denotado por “S” o “Ω ”

- VARIABLE. Se denomina variable a la entidad que puede tomar un valor cualesquiera durante la

- duración de un proceso dado. Si la variable toma un solo valor durante el proceso se llama constante.

- VARIABLE ALEATORIA: Es una función que asocia un número real a cada elemento del espacio

- muestral. Es decir son aquellas que pueden diferir de una respuesta a otra.

- Una variable aleatoria se puede clasificar en:

- Variable aleatoria discreta.

- Variable aleatoria continua.

- Variable aleatoria discreta. Una variable discreta proporciona datos que son llamados datos

- cuantitativos discretos y son respuestas numéricas que resultan de un proceso de conteo.

- La cantidad de alumnos regulares en un grupo escolar.

- El número de águilas en cinco lanzamientos de una moneda.

- Número de circuitos en una computadora.

- El número de vehículos vendidos en un día, en un lote de autos

- Variable aleatoria continua. Es aquella que se encuentra dentro de un intervalo comprendido entre dos

- valores cualesquiera; ésta puede asumir infinito número de valores y éstos se pueden medir.

- La estatura de un alumno de un grupo escolar.

- El peso en gramos de una moneda.

- La edad de un hijo de familia.

- Las dimensiones de un vehículo.

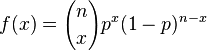

Distribución binomial

- En estadística, la distribución binomial es una distribución de probabilidad discreta que cuenta el número de éxitos en una secuencia de n ensayos de Bernoulli independientes entre sí, con una probabilidad fija p de ocurrencia del éxito entre los ensayos. Un experimento de Bernoulli se caracteriza por ser dicotómico, esto es, sólo son posibles dos resultados. A uno de estos se denomina éxito y tiene una probabilidad de ocurrencia p y al otro, fracaso, con una probabilidad q = 1 - p. En la distribución binomial el anterior experimento se repite n veces, de forma independiente, y se trata de calcular la probabilidad de un determinado número de éxitos. Para n = 1, la binomial se convierte, de hecho, en una distribución de Bernoulli.Para representar que una variable aleatoria X sigue una distribución binomial de parámetros n y p, se escribe:

Ejemplos

Las siguientes situaciones son ejemplos de experimentos que pueden modelizarse por esta distribución:- Se lanza un dado diez veces y se cuenta el número X de tres obtenidos: entonces X ~ B(10, 1/6)

- Se lanza una moneda dos veces y se cuenta el número X de caras obtenidas: entonces X ~ B(2, 1/2)

Experimento binomial

Existen muchas situaciones en las que se presenta una experiencia binomial. Cada uno de los experimentos es independiente de los restantes (la probabilidad del resultado de un experimento no depende del resultado del resto). El resultado de cada experimento ha de admitir sólo dos categorías (a las que se denomina éxito y fracaso). Las probabilidades de ambas posibilidades han de ser constantes en todos los experimentos (se denotan como p y q o p y 1-p).Se designa por X a la variable que mide el número de éxitos que se han producido en los n experimentos.Cuando se dan estas circunstancias, se dice que la variable X sigue una distribución de probabilidad binomial, y se denota B(n,p)Características analíticas

Su función de probabilidad esdonde

Ejemplo

Supongamos que se lanza un dado (con 6 caras) 50 veces y queremos conocer la probabilidad de que el número 3 salga 20 veces. En este caso tenemos una X ~ B(50, 1/6) y la probabilidad sería P(X=20):Propiedades

Relaciones con otras variables aleatorias

Si tiende a infinito y

tiende a infinito y  es tal que el producto entre ambos parámetros tiende a

es tal que el producto entre ambos parámetros tiende a  , entonces la distribución de la variable aleatoria binomial tiende a una distribución de Poissonde parámetro

, entonces la distribución de la variable aleatoria binomial tiende a una distribución de Poissonde parámetro  .Por último, se cumple que cuando

.Por último, se cumple que cuando =0.5 y n es muy grande (usualmente se exige que

=0.5 y n es muy grande (usualmente se exige que  ) la distribución binomial puede aproximarse mediante la distribución normal.

) la distribución binomial puede aproximarse mediante la distribución normal.Propiedades reproductivas

Dadas n variables binomiales independientes de parámetros ni (i = 1,..., n) y , su suma es también una variable binomial, de parámetros n1+... + nn, y

, su suma es también una variable binomial, de parámetros n1+... + nn, y  , es decir,

, es decir,

Esperanza matemática

En estadística la esperanza matemática (también llamada esperanza, valor esperado, media poblacional o media) de una variable aleatoria , es el número

, es el número ![\operatorname{E}[X]](http://upload.wikimedia.org/math/8/d/0/8d03ba387a5f20b58a95980a43bdbfa4.png) que formaliza la idea de valor medio de un fenómeno aleatorio.Cuando la variable aleatoria es discreta, la esperanza es igual a la suma de la probabilidad de cada posible suceso aleatorio multiplicado por el valor de dicho suceso. Por lo tanto, representa la cantidad media que se "espera" como resultado de un experimento aleatorio cuando la probabilidad de cada suceso se mantiene constante y el experimento se repite un elevado número de veces. Cabe decir que el valor que toma la esperanza matemática en algunos casos puede no ser "esperado" en el sentido más general de la palabra - el valor de la esperanza puede ser improbable o incluso imposible.Por ejemplo, el valor esperado cuando tiramos un dado equilibrado de 6 caras es 3,5. Podemos hacer el cálculoy cabe destacar que 3,5 no es un valor posible al rodar el dado. En este caso, en el que todos los sucesos son de igual probabilidad, la esperanza es igual a la media aritmética.Una aplicación común de la esperanza matemática es en las apuestas o los juegos de azar. Por ejemplo, la ruleta americana tiene 38 casillas equiprobables. La ganancia para acertar una apuesta a un solo número paga de 35 a 1 (es decir, cobramos 35 veces lo que hemos apostado y recuperamos la apuesta, así que recibimos 36 veces lo que hemos apostado). Por tanto, considerando los 38 posibles resultados, la esperanza matemática del beneficio para apostar a un solo número es:que es -0,0526 aproximadamente. Por lo tanto uno esperaría, en media, perder unos 5 céntimos por cada euro que apuesta, y el valor esperado para apostar 1 euro son 0.9474 euros. En el mundo de las apuestas, un juego donde el beneficio esperado es cero (no ganamos ni perdemos) se llama un "juego justo".Nota: El primer paréntesis es la "esperanza" de perder tu apuesta de 1€, por eso es negativo el valor. El segundo paréntesis es la esperanza matemática de ganar los 35€. La esperanza matemática del beneficio es el valor esperado a ganar menos el valor esperado a perder.

que formaliza la idea de valor medio de un fenómeno aleatorio.Cuando la variable aleatoria es discreta, la esperanza es igual a la suma de la probabilidad de cada posible suceso aleatorio multiplicado por el valor de dicho suceso. Por lo tanto, representa la cantidad media que se "espera" como resultado de un experimento aleatorio cuando la probabilidad de cada suceso se mantiene constante y el experimento se repite un elevado número de veces. Cabe decir que el valor que toma la esperanza matemática en algunos casos puede no ser "esperado" en el sentido más general de la palabra - el valor de la esperanza puede ser improbable o incluso imposible.Por ejemplo, el valor esperado cuando tiramos un dado equilibrado de 6 caras es 3,5. Podemos hacer el cálculoy cabe destacar que 3,5 no es un valor posible al rodar el dado. En este caso, en el que todos los sucesos son de igual probabilidad, la esperanza es igual a la media aritmética.Una aplicación común de la esperanza matemática es en las apuestas o los juegos de azar. Por ejemplo, la ruleta americana tiene 38 casillas equiprobables. La ganancia para acertar una apuesta a un solo número paga de 35 a 1 (es decir, cobramos 35 veces lo que hemos apostado y recuperamos la apuesta, así que recibimos 36 veces lo que hemos apostado). Por tanto, considerando los 38 posibles resultados, la esperanza matemática del beneficio para apostar a un solo número es:que es -0,0526 aproximadamente. Por lo tanto uno esperaría, en media, perder unos 5 céntimos por cada euro que apuesta, y el valor esperado para apostar 1 euro son 0.9474 euros. En el mundo de las apuestas, un juego donde el beneficio esperado es cero (no ganamos ni perdemos) se llama un "juego justo".Nota: El primer paréntesis es la "esperanza" de perder tu apuesta de 1€, por eso es negativo el valor. El segundo paréntesis es la esperanza matemática de ganar los 35€. La esperanza matemática del beneficio es el valor esperado a ganar menos el valor esperado a perder.Definición

Para una variable aleatoria discreta con valores posibles y sus probabilidades representadas por la función de probabilidad

y sus probabilidades representadas por la función de probabilidad  la esperanza se calcula como:Para una variable aleatoria absolutamente continua, la esperanza se calcula mediante la integral de todos los valores y la función de densidad

la esperanza se calcula como:Para una variable aleatoria absolutamente continua, la esperanza se calcula mediante la integral de todos los valores y la función de densidad :La definición general de esperanza se basa, como toda la teoría de la probabilidad, en el marco de la teoría de la medida y se define como la siguiente integral:La esperanza también se suele simbolizar con

:La definición general de esperanza se basa, como toda la teoría de la probabilidad, en el marco de la teoría de la medida y se define como la siguiente integral:La esperanza también se suele simbolizar con![\mu = E[X] \,\!](http://upload.wikimedia.org/math/3/2/7/3279ba1ddb2ac80fce25a62bee4a55f4.png) No todas las variables aleatorias tienen un valor esperado. Por ejemplo, la distribución de Cauchy no lo tiene.

No todas las variables aleatorias tienen un valor esperado. Por ejemplo, la distribución de Cauchy no lo tiene.Propiedades

Constantes

La esperanza matemática de una constante es igual a esa misma constante, es decir, si c es una constante, entonces E[c] = c.Linealidad

La esperanza es un operador lineal, ya que:![\operatorname{E}[X + c]= \operatorname{E}[X] + c \,\!](http://upload.wikimedia.org/math/8/5/a/85a00d2da36ee53533b8d5f1e9842642.png)

![\operatorname{E}[X + Y]= \operatorname{E}[X] + \operatorname{E}[Y] \,\!](http://upload.wikimedia.org/math/a/1/5/a15cbeacea501a46fb32656efc4a870c.png) (*)

(*)![\operatorname{E}[aX]= a \operatorname{E}[X] \,\!](http://upload.wikimedia.org/math/4/b/d/4bdd6ba758248cbe75c558a1a34fdec6.png)

por ende:![\operatorname{E}[a X + b Y] = a \operatorname{E}[X] + b \operatorname{E}[Y] \,\!](http://upload.wikimedia.org/math/2/3/d/23db5270f4369a806d5c98e254da0c3f.png) donde

donde e

e  son variables aleatorias y

son variables aleatorias y  y

y  son dos constantes cualesquiera.Nótese que (*) es válido incluso si X no es independiente de Y.

son dos constantes cualesquiera.Nótese que (*) es válido incluso si X no es independiente de Y.Teorema de Bayes

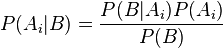

En la teoría de la probabilidad el teorema de Bayes es un resultado enunciado por Thomas Bayes en 17631 que expresa la probabilidad condicional de un evento aleatorio Adado B en términos de la distribución de probabilidad condicional del evento B dado A y la distribución de probabilidad marginal de sólo A.En términos más generales y menos matemáticos, el teorema de Bayes es de enorme relevancia puesto que vincula la probabilidad de A dado B con la probabilidad de B dado A. Es decir que sabiendo la probabilidad de tener un dolor de cabeza dado que se tiene gripe, se podría saber (si se tiene algún dato más), la probabilidad de tener gripe si se tiene un dolor de cabeza, muestra este sencillo ejemplo la alta relevancia del teorema en cuestión para la ciencia en todas sus ramas, puesto que tiene vinculación íntima con la comprensión de la probabilidad de aspectos causales dados los efectos observados.

-

- Sea

un conjunto de sucesos mutuamente excluyentes y exhaustivos, y tales que la probabilidad de cada uno de ellos es distinta de cero (0). Sea B un suceso cualquiera del que se conocen las probabilidades condicionales

un conjunto de sucesos mutuamente excluyentes y exhaustivos, y tales que la probabilidad de cada uno de ellos es distinta de cero (0). Sea B un suceso cualquiera del que se conocen las probabilidades condicionales  . Entonces, la probabilidad

. Entonces, la probabilidad  viene dada por la expresión:

viene dada por la expresión: donde:

donde: son las probabilidades a priori.

son las probabilidades a priori. es la probabilidad de

es la probabilidad de  en la hipótesis

en la hipótesis  .

. son las probabilidades a posteriori.

son las probabilidades a posteriori.

Fórmula de Bayes

Con base en la definición de Probabilidad condicionada, obtenemos la Fórmula de Bayes, también conocida como la Regla de Bayes:

Aplicaciones

El teorema de Bayes es válido en todas las aplicaciones de la teoría de la probabilidad. Sin embargo, hay una controversia sobre el tipo de probabilidades que emplea. En esencia, los seguidores de la estadística tradicional sólo admiten probabilidades basadas en experimentos repetibles y que tengan una confirmación empírica mientras que los llamados estadísticos bayesianos permiten probabilidades subjetivas. El teorema puede servir entonces para indicar cómo debemos modificar nuestras probabilidades subjetivas cuando recibimos información adicional de un experimento. La estadística bayesiana está demostrando su utilidad en ciertas estimaciones basadas en el conocimiento subjetivo a priori y el hecho de permitir revisar esas estimaciones en función de la evidencia empírica es lo que está abriendo nuevas formas de hacer conocimiento. Una aplicación de esto son los clasificadores bayesianos que son frecuentemente usados en implementaciones de filtros de correo basura o spam, que se adaptan con el uso.Como observación, se tiene y su demostración resulta trivial.

y su demostración resulta trivial.

-

-

-

las

las  en

en  (

(

![\mathbb{E}[X] = np\,](http://upload.wikimedia.org/math/3/e/c/3ec567691d864b73ee9a0f991c0d4026.png)

![\mathbb{V}\text{ar}[X] =np(1-p)\,](http://upload.wikimedia.org/math/0/f/8/0f82ec44d890e66e62e1a266c2357104.png)

![\begin{align}

\operatorname{E}(X) = 1 \cdot \frac{1}{6} + 2 \cdot \frac{1}{6} + 3 \cdot \frac{1}{6}

+ 4 \cdot \frac{1}{6} + 5 \cdot \frac{1}{6} + 6 \cdot \frac{1}{6}\\[6pt] = \frac{1 + 2 + 3 + 4 + 5 + 6}{6} = 3,5

\end{align}](http://upload.wikimedia.org/math/0/f/a/0fa54d97224666f235b06c03d40c4d8b.png)

![E[X]=x_1p(X=x_1)+...+x_np(X=x_n)=E[X]=\sum_{i=1}^{n} x_i p(x_i) \,\!](http://upload.wikimedia.org/math/6/5/4/6542d1cb9b9c9aec822f1dd1a8987b96.png)

![E[X]=\int_{-\infty}^\infty x f(x)dx \,\!](http://upload.wikimedia.org/math/0/1/e/01ee197ad5dbb61b90d3ed7de412f720.png)

![\operatorname{E}[X] = \int_\Omega X\, \operatorname{d}P \,\!](http://upload.wikimedia.org/math/1/8/8/1886dcd2c6879b5a00239e1661cca761.png)

![E[X^k] \,\!](http://upload.wikimedia.org/math/f/7/1/f71df20458573663d1d38537e4e2b082.png) para

para  se llaman momentos de orden

se llaman momentos de orden  . Más importantes son los

. Más importantes son los ![E[(X-E[X])^k] \,\!](http://upload.wikimedia.org/math/a/1/2/a1293ec70351b19f815480e7e2c63840.png) .

.

No hay comentarios.:

Publicar un comentario